【新闻稿】”基于能量的神经网络”讲座

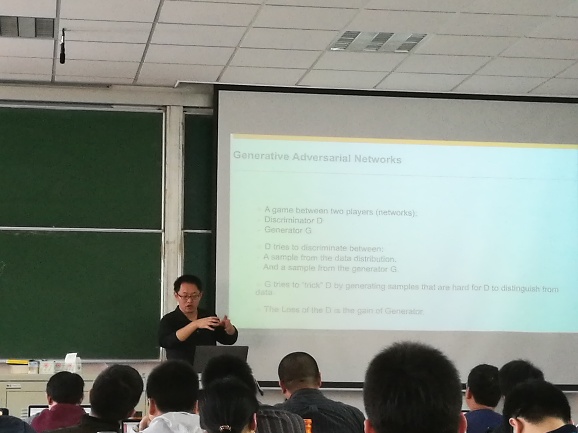

2017年4月22日下午,由复旦CS创新创业中心、清平道场、MSE Club、金融IT人才标准研究中心联合举办了一场创新创业讲座,本次讲座邀请了SAP硅谷创新中心数据科学家邬学宁先生,于邯郸校区第三教学楼给学生们做了一场“基于能量的神经网络”讲座。

讲座主题围绕“生成对抗网络”从自动编码器(auto-encoder)概念复习入手,分析降维在数据集学习中的实际应用。在系统中放入随机数,通过学习可生成合理图像。随后,由网络博弈论的方法,介绍零和博弈理论,其中常见解决方法包括minimax theory,在某一情况下采取最有效策略,让不同网络互相竞争,通过博弈关系提高性能。生成模型(generative model)工作原理,模型产生看似自然的数据样本,可拟合出任何复杂的模型分布,即神经网路的表达力是无穷的。神经网络在降噪方面有独特的工作机制,GAN包含描述和生成模型,借助数学推导,详细分析了损耗函数(loss function)在GAN中的工作原理。GAN应用广泛,包括图像锐化,文字生成图像,图像网络,图像数据库的分类等。与开源同样重要的是权重,转移学习(transfer learning)即包括权重,可基于识别训练后的权重直接应用。在五花八门的图像中,集中针对某一特征进行改进优化,大大减少训练的工作量。讲座第二部分强化学习部分,主讲人从巴甫洛夫经典实验入手,学习并非一定在结果中产生,而在实际回报和差异中发生,差异与多巴胺有关,差异越大,多巴胺分泌越多。借助实例,区别了监督式学习和非监督学习,以及强化学习与两者的差异。强化学习的定义是学习怎样将解决路径投射到行动上,以便最大化数字化回报信号(numerical reward signal)广泛应用在无人自行车、智能机器人,金融领域等,可适应不同环境。如果让实施者牺牲短期利益获取可能更大的长期利益,是强化学习需要解决的核心问题。探索(exploration)和发掘(exploitation)两者需要平衡和结合,以获得理想结果。强化学习中核心方程是贝尔曼等式(Bellman Equation),可通过动态规划和迭代来实现。Q-learning是强化学习的一种无模型实现。目的是在任何状态下找到回报最大的值,在初始状况随机探索,类似梯度下降。通过多轮迭代,找到Q表格中理想值。考虑的关键是探索问题中如何有效的遍历所有可能的状态,简单方法是对于某给定的状态,总是选择Q最大的动作,不断加入随机性,最终遍历Q表格,可通过动态规划等三种方法实现。

整场讲座在同学们热烈的掌声中结束了,同学们均表示在此次讲座中收获颇丰,受益匪浅,邬学宁先生的精彩分享赢得了同学们的广泛好评。